ouça este conteúdo

Detectores de problemas linguísticos são essenciais para lidar com a complexidade típica de textos acadêmicos e evitar falsos positivos da IA.

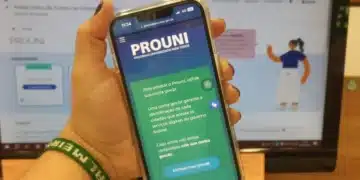

Aqui no Brasil também é comum a utilização de Inteligência Artificial para a criação de textos, gerados por programas como o ChatGPT. A importância da autenticidade e originalidade dos conteúdos também é evidente em cenários acadêmicos por aqui.

Os textos produzidos por Inteligência Artificial estão cada vez mais presentes, sendo essencial garantir a originalidade do conteúdo gerado por esses programas. A autenticidade é crucial em ambientes acadêmicos, onde a procedência e a qualidade dos textos são fatores determinantes.

Desafios dos Detectores de Textos Gerados por IA

À medida que cresce a demanda por detectores de textos produzidos por Inteligência Artificial, surgem problemas e demandas que precisam ser considerados por professores, pesquisadores e editores. A função principal desses detectores é analisar uma variedade de recursos linguísticos, como a estrutura das frases, a escolha de palavras e os elementos estilísticos presentes nos textos gerados por IA.

Essas ferramentas utilizam algoritmos de aprendizado de máquina treinados em conjuntos de dados extensos para identificar padrões típicos de textos gerados por Inteligência Artificial. Alguns desses padrões estão relacionados à imprevisibilidade do texto e à capacidade de deixar o leitor perplexo. Enquanto os textos gerados por IA tendem a ser mais previsíveis e de fácil compreensão, a escrita humana geralmente apresenta maior complexidade, com linguagem mais criativa, mas também sujeita a erros.

Um dos padrões avaliados pelos detectores é a variação na estrutura e comprimento das frases. Textos com poucas variações desse tipo são mais propensos a ter sido gerados por IA, enquanto textos com maior diversidade provavelmente foram escritos por humanos. Os modelos de linguagem utilizados pela Inteligência Artificial tendem a produzir frases de comprimento médio e estruturas convencionais, o que pode resultar em uma escrita que parece monótona.

A precisão dos detectores varia significativamente dependendo da complexidade do texto, da língua e da sofisticação da IA geradora. Problemas como falsos positivos e falsos negativos são questões frequentemente discutidas no meio acadêmico. Falsos positivos ocorrem quando um texto escrito por humanos é erroneamente identificado como gerado por IA, enquanto falsos negativos acontecem quando o conteúdo de IA é classificado como sendo de origem humana.

Esses erros podem ter sérias consequências, principalmente em ambientes acadêmicos, onde acusações de plágio podem resultar em danos à reputação e carreira, processos legais e desconforto em sala de aula. É fundamental evitar acusações infundadas e fazer uma verificação cuidadosa da concordância entre as ferramentas de detecção e o julgamento pessoal, combinando com a experiência individual para uma avaliação mais precisa.

Corrida Armamentista entre Geradores e Detectores de Conteúdo de IA

Um dos desafios enfrentados é manter os detectores atualizados em relação ao constante avanço dos textos gerados por IA. À medida que os modelos de Inteligência Artificial se tornam mais sofisticados, seus resultados se aproximam cada vez mais da escrita humana, tornando a identificação das diferenças mais complexa para os detectores.

Essa corrida para acompanhar a evolução do conteúdo de IA demanda aprimoramentos contínuos nos algoritmos de detecção. Até o momento, encontrar uma ferramenta totalmente confiável que distinga textos gerados por IA de textos humanos ainda é um desafio. Os estágios iniciais da detecção de IA requerem cautela e verificação cuidadosa para evitar equívocos e garantir a integridade acadêmica e profissional.

Fonte: © G1 – Globo Mundo