Segundo Dario Amodei, CEO da Anthropic, IAs com alto nível de autonomia representam risco para segurança em armas biológicas com risco relativamente baixo.

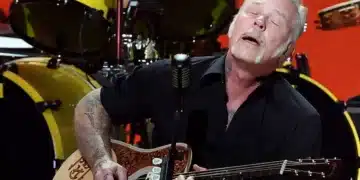

O CEO da startup Anthropic e ex-vice-presidente de Pesquisa da OpenAI, Dario Amodei, trouxe à tona um alerta importante durante uma entrevista recente, destacando a crescente preocupação em relação ao futuro da Inteligência Artificial (IA). Segundo suas previsões, entre 2025 e 2028, as IAs poderão atingir um nível de autonomia que levantará questões críticas sobre segurança e controle, gerando impactos significativos em escala global. Essa visão oferece uma nova perspectiva sobre o desenvolvimento e a regulação das tecnologias de Inteligência Artificial.

A Anthropic, sob a liderança de Dario Amodei, atua no estabelecimento de protocolos de segurança para as IAs, abordando aspectos fundamentais que envolvem sua evolução e aplicação prática. A conscientização quanto aos desafios e oportunidades relacionados à IA é essencial para garantir um progresso sustentável e ético neste campo em constante evolução. A comunidade global deve continuar a promover discussões e ações colaborativas para moldar um futuro equilibrado e seguro com a presença cada vez maior da Inteligência Artificial.

Desenvolvimento da Inteligência Artificial em Diferentes Níveis de Autonomia

Amodei discute a atual posição da inteligência artificial no ‘nível 2’, onde os modelos de linguagem começam a revelar informações delicadas, como a potencial construção de armas biológicas. No entanto, ele destaca que essas informações ainda carecem de confiabilidade, o que mantém o risco em um patamar relativamente baixo.

A Microsoft recentemente apresentou sua mais nova inovação em IA, capaz de dar vida a imagens estáticas, permitindo que elas falem e se movimentem, ampliando as possibilidades dessa tecnologia em diversas áreas. Enquanto isso, no Web Summit Rio 2024, especialistas debatem os impactos cada vez mais presentes da inteligência artificial em nosso cotidiano.

Um avanço significativo foi alcançado com um exame de sangue guiado por IA, capaz de detectar precocemente nove tipos de câncer, revolucionando a medicina preventiva. No entanto, a preocupação se intensifica ao considerar o próximo estágio, o ‘nível 3’, que poderá ser alcançado em breve.

No ‘nível 3’, o potencial de uma verdadeira catástrofe é mais proeminente, com a ameaça de utilização de tecnologias de IA em armas biológicas e cibernéticas. Amodei ressalta que no nível seguinte, o ‘nível 4’, há especulações sobre características como autonomia, incluindo a capacidade de sistemas se reproduzirem independentemente e persuasão.

A previsão é que modelos de IA desse calibre possam surgir entre 2025 e 2028, o que lança questionamentos sérios sobre a segurança global diante do potencial militar dessas tecnologias. Diante desse cenário, a monitorização cuidadosa do avanço e aplicação de IAs se torna crucial, especialmente considerando a capacidade de estados em ampliar suas forças armadas com essa tecnologia em constante evolução.

Empresas renomadas, como Amazon e Google, estão investindo ativamente em IA, impulsionando o desenvolvimento de novos modelos de linguagem. A Anthropic, por exemplo, lançou seu próprio modelo – o Claude – enfatizando uma abordagem mais responsável em comparação com a OpenAI. A IA da Anthropic já está em sua terceira versão desde março deste ano, demonstrando um progresso constante e promissor nesta era de rápida evolução tecnológica.

Fonte: © CNN Brasil